Vårt omättliga behov av AI lyfter inte bara processortillverkarna med Nvidia i spetsen, det behövs också minneskuber för att försörja dem med data. Räknat i bitar spår Trendforce att HBM-minnena kommer att växa med 260 procent i år.

Vårt omättliga behov av AI lyfter inte bara processortillverkarna med Nvidia i spetsen, det behövs också minneskuber för att försörja dem med data. Räknat i bitar spår Trendforce att HBM-minnena kommer att växa med 260 procent i år.

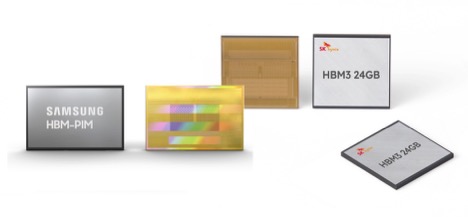

HBM-minnen är komplicerade att tillverka och tar längre tid att tillverka eftersom DRAM-chipsen stackas på varandra som en Dagobertmacka. Belöningen för tillverkarna är samtidigt stor eftersom priset per bit är betydligt högre än för andra DRAM-typer.

För HBM3, som varit i produktion sedan mitten av 2022, finns två varianter med åtta eller tolv stackade DRAM-chip på 16 Gbyte respektive 24 Gbyte. Varje DRAM-chip är nedslipat till 30 µm och sammankopplat med de övriga via anslutningar som går vertikalt genom chipen, så kallade Through Silicon Vias, TSV.

Tillverkarna är på god väg att lansera nästa generation, HBM4, med ännu mer minne och snabbare anslutningar.

Under 2024 spår Trendforce att HBM utgör 20,1 procent av marknaden mätt i pengar, upp från 8,4 procent i fjol. Ser man istället till antalet bitar förväntas HBM bara utgöra 14 procent i år med 250 000 kiselskivor per månad.