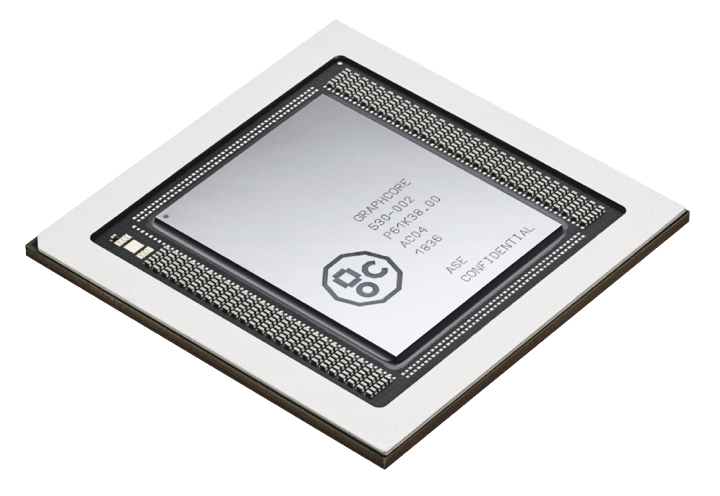

Brittiska Graphcores 16 nm-neuronnätsprocessor Colossous C2 kan nu provköras i Microsofts moln Azure. Prestanda är helt överlägsen grafikprocessorer enligt deras mätningar.

Brittiska Graphcores 16 nm-neuronnätsprocessor Colossous C2 kan nu provköras i Microsofts moln Azure. Prestanda är helt överlägsen grafikprocessorer enligt deras mätningar.

Google har under flera år varit ensamt om att använda skräddarsydda processorer i molnet för neuronnätsberäkningar – om man inte sorterar in Nvidias AI-anpassade grafikprocessorer i den kategorin.

Men nu har snart alltså även Microsoft en dedikerad AI-asic i sitt moln. Hittills är den bara tillgänglig för provkörning. Och det finns inte hur många som helst av den utan du måste ta köbiljett om du vill testa. Av någon anledning får du för övrigt gå före i kön om du har en språktillämpning – NLP, natural language processing.

|

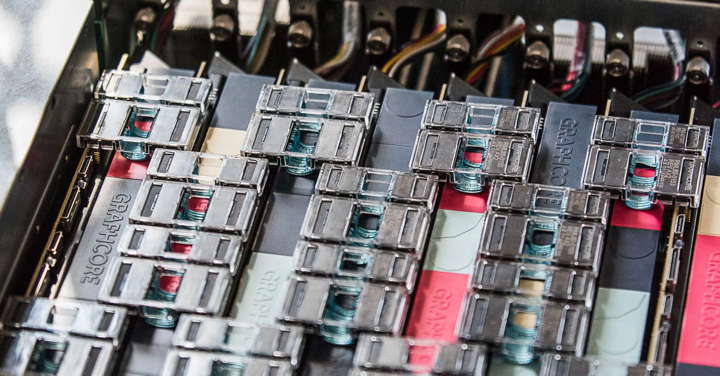

| Graphcore C2, Dell DSS8440, närbild uppifrån på åtta kort med datalänkar och C2:s arkitektur. Klicka för större bilder! |

Redan existerande pilotanvändare finns inom områdena bildigenkänning, finansinvesteringsprocesser, robotik och Slam (att bygga 3d-kartor från film).

Microsoft och Graphcore presenterar ett antal egna prestandamätningar mellan C2 och grafikprocessorer och får ofta betydligt bättre prestanda – 43 gånger högre genomströmning, eller 77 eller 26 gånger i andra test. Eller en 40-del av latensen, eller 18-del. Gräv själv i siffrorna som finns här (länk).

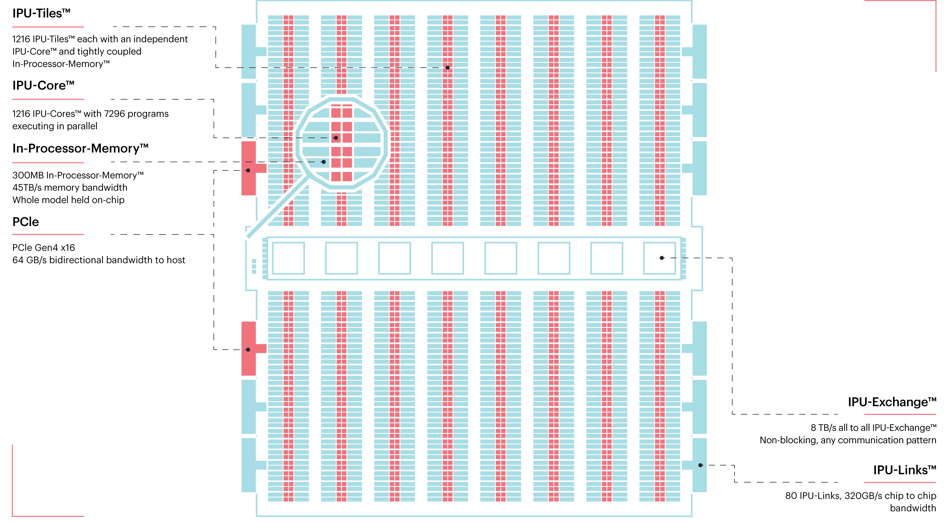

Ha i åtanke när du gräver att i jämförelser mellan processorer är den som är senast tillverkad alltid gynnad eftersom halvledarteknik utvecklas så snabbt. Samtidigt är en av Graphcores idéer att fylla sitt chip med massor av minne, 300 Mbyte enligt tidigare uppgifter eftersom neuronnätsberäkningar kan ha gigantiska minneskrav. Datatrafik är en flaskhals i alla chips och mycket minne på chipet är precis en sådan detalj som kan tänkas ge utslag i den här storleksordningen om du använder stora neuronnät eller snabbt vill växla mellan flera olika neuronnät eller om du tränar ett neuronnät med en stor datavolym.

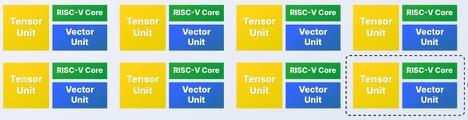

Graphcores minne överträffades plötsligt med råge när amerikanska Cerebras i augusti lanserade ett chip, ja, ett chip, med 18 Gbyte minne, ja, gigabyte. Chipet är nämligen gigantiskt. Det är det första chip i världshistorien som tillverkats av en enda kiselskiva.

Graphcores motdrag i marknadsföringen blev att byta perspektiv och beskriva Cerebras jättechip som i själva verket bestående 84 stycken sammankopplade processorkärnor, vilket arkitekturmässigt är helt sant. Därmed tycker Graphcore att matchen inte alls är avgjord utan hoppas kunna bjuda motstånd genom att bygga egna superarkitekturer genom att pussla samman många chips med snabba länkar.

Cerebras hade lovat prestandamätningar redan i slutet av september, men de har inte dykt upp ännu.

Den allmänna startsignalen för skräddarsydda AI-chips i molnet kom i maj 2016 när Google avslöjade att det redan hade ett sedan ett år. Graphcore var en av många AI-chiputvecklare som därefter snabbt fick finansiering. Fram till slutet av 2017 drog företaget in en dryg miljard kronor i tre finansieringsomgångar. I december kom ytterligare två miljarder kronor, från bland annat Microsoft och efter det värderades Graphcore till 160 miljarder kronor.

C2 kan programmeras med hjälp av ett verktyg kallat Poplar. Men det behöver du strängt taget inte veta, för du kan fortsätta att använda existerande utvecklingsplattformar för Tensorflow och ONNX. Därefter översätter Poplar dina modeller automatiskt till C2:s arkitektur. Också Py Torch-översättning kommer att börja stödjas under detta fjärde kvartal.

Graphcore och Microsoft började samarbeta i Cambridge i Storbritannien redan år 2017. Microsofts bidrag i samarbetet har varit att göra C2-servrarna åtkomliga via Azure. Dessutom har förstås Microsoft inte kunnat låta bli att självt leka med C2 och har bland annat utvecklat nätverk för datorseende och språkförståelse där Microsoft säger sig ha gjort framsteg inom en NLP-metod kallad Bert.

Servern är byggd av Dell, som är en annan av Graphcores investerare. Den består av åtta stycken kort med två C2-processorer vardera. Korten är sammankopplade via en teknik kallad IPU-Link. Chassit har storleken 4U. Prestanda anges till 1,6 petaflops – 1,6 biljarder flyttalsoperationer per sekund.

En uppföljare till C2 i 7 nm är under utveckling.

En annan molnjätte, Amazon, använder idag Nvidia-grafikprocessorer, men är i färd med att utveckla en egen chiparkitektur för inferenser kallad Inferentia. Kinesiska ehandelsjätten Alibaba presenterade sin första AI-accelerator i september, kallad Hanguang.

IBM har en neuronnätsprocessor på gång till nästa år för sitt moln, som idag använder Nvidia-GPU:er. Dessutom har IBM ett antal vildare långtidsprojekt kring idéer som analoga beräkningar, memristorer och kvantdatorer som företaget satsat två miljarder dollar i.*

FOTNOT:

(*) Texten är korrigerad